반응형

개요

- optimization - 손실 함수의 값을 최소화하는 것이 목표로 최적화한다.

- otpimizer - 이를 수행하는 알고리즘, 즉 최적화 알고리즘

- 완벽한 이해에 수학적 지식이 필요함으로 추후 추가 학습이 필요함

- adam은 자주 쓰이는 otpimizer의 한 종

optimizer 종류

- 기본적을 GD→ SGD, 이후 SGD에서 분화됨

ADAM

- 가장 많이 쓰는 optimizer

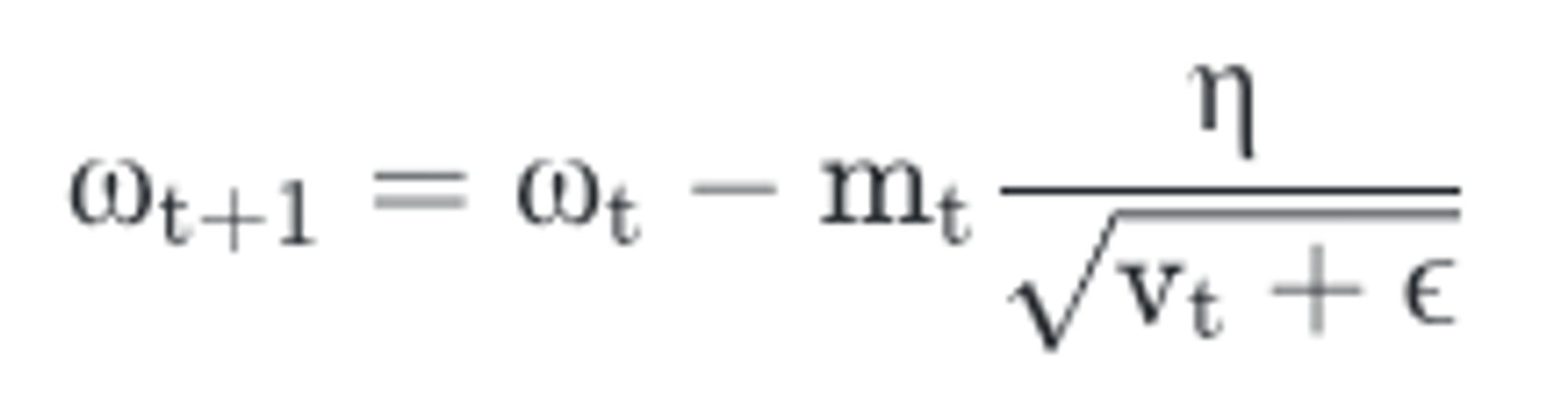

- Momentum, RMSProp을 섞어 사용

- 관성, 이전 학습률 고려

- bounded step size

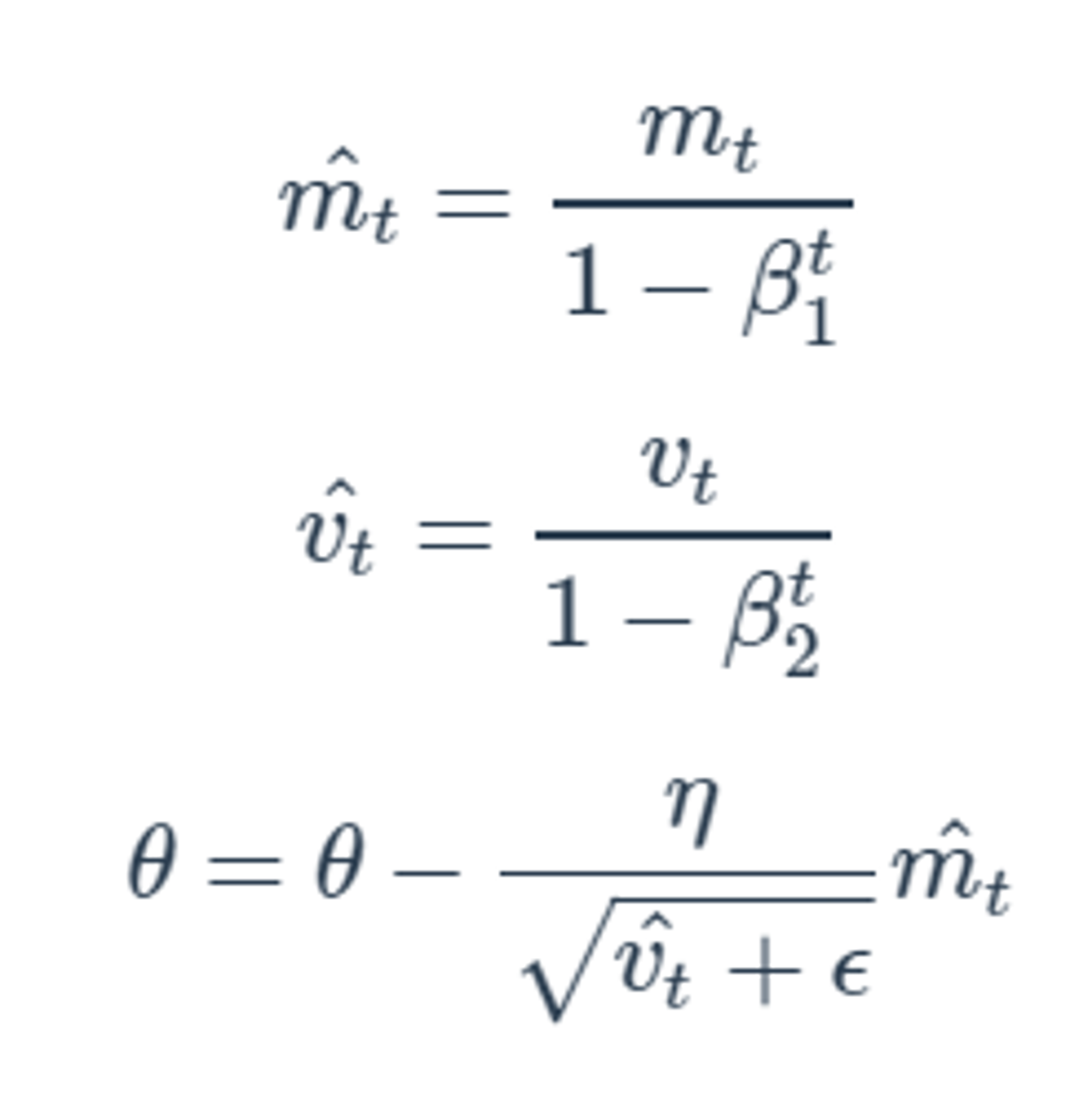

- 기울기의 지수평균

- 기울기의 제곱값의 지수평균

- 편향 문제를 해결하기 위해서 위 두 값에 보정이 들어

- 하이퍼 파라미터

- 보통 다른 값들은 위와 같이 고정하고 에타를 여러 값으로 시도하면서 최적의 값을 찾는다.

- 아담에 대한 추가적인 리뷰… 더 복잡해서 일단 추후로 미룬다…

ADAM : A METHOD FOR STOCHASTIC OPTIMIZATION 리뷰

ADAM : A METHOD FOR STOCHASTIC OPTIMIZATION 리뷰

작성자 1 : 한양대학원 융합로봇시스템학과 유승환 석사과정 (CAI LAB) 작성자 2 : 한양대학교 로봇공학과 정석훈 학부생 오늘은 optimizer 알고리즘 중 하나인 Adam에 대해 공부해보겠습니다~ 딥러닝

ropiens.tistory.com

- 아담 논문

https://arxiv.org/abs/1609.04747

An overview of gradient descent optimization algorithms

Gradient descent optimization algorithms, while increasingly popular, are often used as black-box optimizers, as practical explanations of their strengths and weaknesses are hard to come by. This article aims to provide the reader with intuitions with rega

arxiv.org

- 아담에 대한 논문 리뷰

https://www.youtube.com/watch?v=sIjVu2xnTfI

반응형

'ai' 카테고리의 다른 글

| 미로 찾기 강화학습 과제 후기(3가지 열쇠, 3가지의 문 그리고 Q learning을 곁들인) (1) | 2024.11.10 |

|---|---|

| qwk metrics (0) | 2024.05.09 |

| 분류 평가 지표 (0) | 2024.03.18 |